Foto: BLINKER

Projekt Blinker: Navigieren mit 360°-Kamera

Industrielle Prozesse sind heute in hohem Maße mit Automatisierungsanforderungen verbunden. Wesentliche Bestandteile moderner Lager- und Transportprozesse sind daher (teil-)autonome Systeme wie mobile Roboter, fahrerlose Transportsysteme oder Gabelstaplersteuerungssysteme. Herkömmliche Navigationsmethoden stellen jedoch ein Hindernis dar, wenn es um die Forderung nach Flexibilität und Wirtschaftlichkeit geht. Im Projekt BLINKER arbeiten die Wissenschaftler in Kooperation mit einem mittelständischen Unternehmen an einem Sensor für die autonome Navigation von Fahrzeugen.

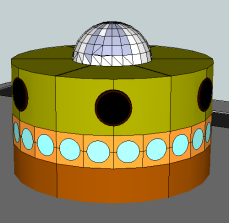

Intelligente Bildverarbeitung

Der Sensor wird es dem mobilen System ermöglichen, seine eigene Pose (Position und Orientierung) in seiner Umgebung präzise zu bestimmen und zu regulieren. Das System wird in der Lage sein, sich sowohl an künstlichen retroreflektierenden Markierungen als auch an natürlichen Landmarken zu orientieren, zum Beispiel mit Hilfe von Deep-Learning-Ansätzen. Technologisch basiert der Ansatz auf der Fusion mehrerer Kameras, einer LED-Beleuchtungseinheit und intelligenter Bildverarbeitung. Die Kameras sind auf einem Ring angeordnet, so dass die Marken über den gesamten Horizont (360°) erfasst werden können. Zusätzlich ist eine nach oben gerichtete Kamera vorgesehen. Somit kann die zu entwickelnde 360°-Kamera eine "Halbkugel" erfassen. Durch Bildverarbeitung der (künstlichen oder natürlichen) Markierungen kann mittels eines Triangulationsalgorithmus die genaue Position berechnet werden.

Bei der Entwicklung der Umgebungskamera wird besonderes Augenmerk auf die Verarbeitung der visuellen Informationen gelegt. Neben natürlichen Landmarken im Innen- und Außenbereich soll die Kamera auch sicherheitskritische Objekte wie Personen oder Hindernisse zuverlässig erkennen und verfolgen. Dies ermöglicht die Anreicherung mit semantischen Informationen und damit völlig neue Dienste in der Industrie.

In einer ersten Phase lernt das System seine Umgebung kennen und lokalisiert Bilder anhand von Positionskoordinaten. Diese Bildsignal-Koordinaten-Paare werden als Trainingsdaten für ein deep neural network verwendet, so dass es automatisch eine passende Zuordnung lernt und aus bisher ungesehenen Bildern eine 3D-Position schätzen kann.

Kontakt

Prof. Dr.-Ing. Bodo Rosenhahn

Bodo Rosenhahn ist Professor am Institut für Informationsverarbeitung der Leibniz Universität Hannover, wo er die Abteilung für automatische Bildinterpretation leitet. Er ist Vorstandsmitglied des L3S.